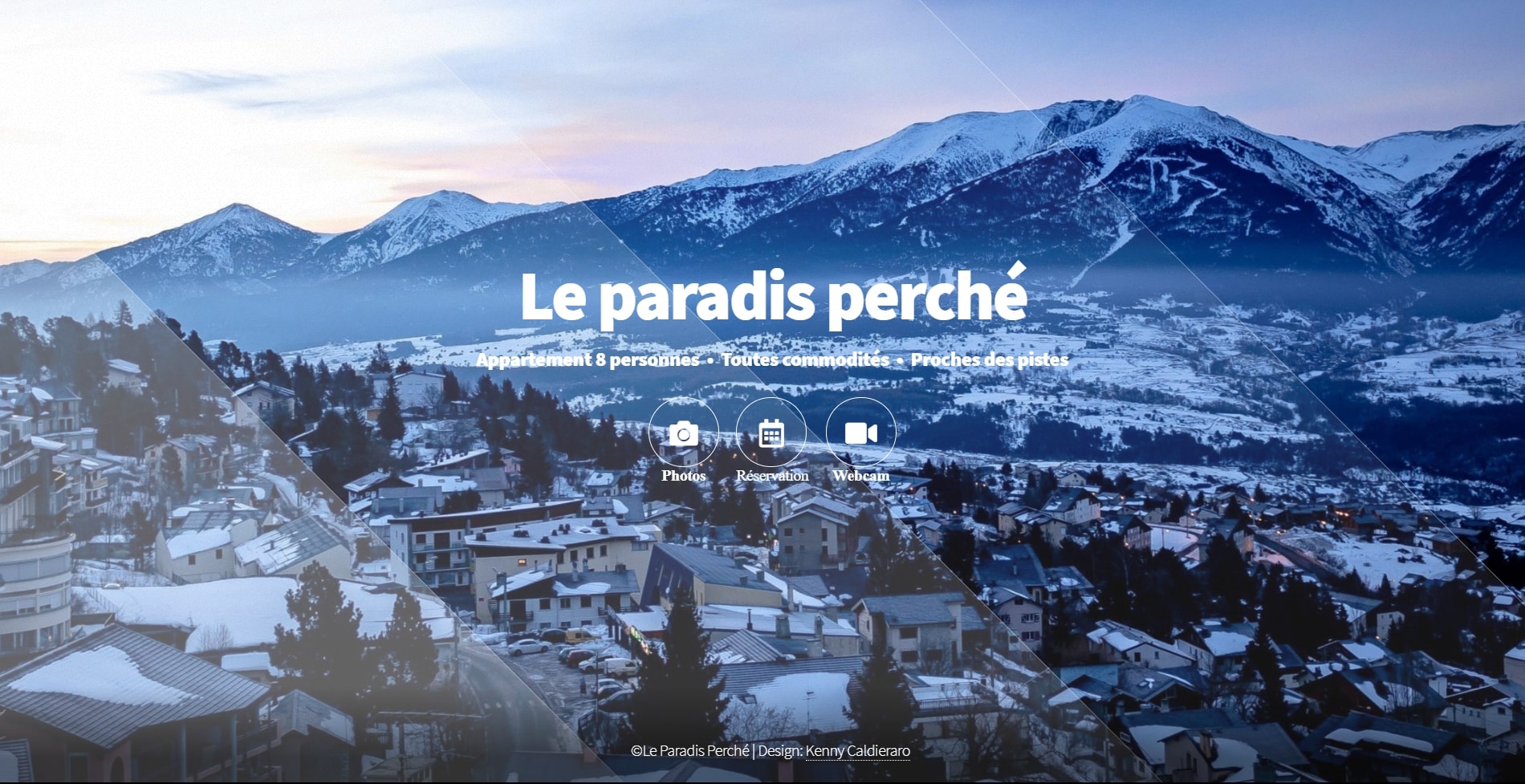

Site de présentation, gestion locative, et réservation gite

Que se passera-t-il après ChatGPT et Midjourney ? Derrière l’essor des outils d’intelligence artificielle (IA) générative, capables de créer des textes et des images, sur quoi travaillent les géants du secteur ? Au Festival du Monde, dimanche 17 septembre, Naila Murray a évoqué les pistes de recherche de Meta, la maison mère de Facebook et d’Instagram, dont elle dirige les laboratoires d’IA de Paris, Londres, Zurich et Tel-Aviv.

Les grands modèles de traitement du langage – sur lesquels s’appuient de nombreux outils, dont ChatGPT – « ont une logique statistique » et « ne peuvent pas encore raisonner et planifier », a pointé du doigt Mme Murray. Une façon d’expliquer que ces logiciels se bornent à créer des textes réalistes, ressemblant aux milliards de pages qu’ils ont ingurgitées. Dans ses recherches fondamentales, Meta travaille donc sur des IA qui seraient dotées de ces capacités et qui pourraient se forger une « représentation du monde ».

Derrière cette expression abstraite, se cache l’idée de permettre à des logiciels d’apprendre des choses, sans supervision humaine, en regardant des vidéos ou même en observant la réalité, via des capteurs vidéo. « Cela s’inspire de la faculté qu’ont les humains ou les animaux de comprendre comment le monde fonctionne, ce qui leur permet de faire des prédictions : s’ils voient une personne marcher, ils s’attendent à ce qu’elle pose son pied par terre car ils comprennent ce qu’est la marche. S’ils me voient jeter une balle en l’air, ils savent qu’elle va redescendre, etc. », a expliqué Mme Murray.

Dans cet esprit, Yann LeCun, le directeur de la recherche en intelligence artificielle chez Meta, a lancé en juin I-Jepa, une tentative de créer un nouveau modèle d’IA capable d’apprendre, en ingurgitant des images, des représentations abstraites des choses (les jambes d’un chien, le front d’un chien, etc.), sans pour autant faire l’effort d’en analyser chaque pixel, comme le font les logiciels actuels de génération d’image. Le but est d’imiter le « bon sens » humain. Et de créer à terme, des machines qui « apprennent beaucoup plus vite, planifient comment accomplir des tâches complexes et s’adaptent à des situations inattendues », explique l’entreprise. M. LeCun, l’un des chercheurs français connu comme un des pères de l’IA moderne, a parfois donné l’exemple d’un logiciel capable, si on lui demandait d’organiser un trajet Paris-New York, de donner le chemin pour sortir de l’immeuble, de commander un taxi, de nous guider à l’aéroport, d’acheter un billet d’avion, etc.

Il vous reste 52.19% de cet article à lire. La suite est réservée aux abonnés.

Aucun commentaire n'a été posté pour l'instant.